Betreuer:Rolf Kruse (Vertretungsprofessur Mediendesign), Prof. Dr. Paul Grimm (Prof. Graph. Datenverarbeitung, FH Erfurt, ab 6/2011: HS Fulda)

1 Einleitung

Natürliche intuitive Interaktion für breite Nutzergruppen ist ein aktuelles Thema der Forschung. Neben Multitouch-Anwendungen und haptischen Interaktionsformen steht vor allem die Weiterentwicklung von berührungslosen Steuerungen ohne weitere Eingabegeräte im Fokus.

Im Rahmen der Module Virtual Reality und Natural User Interfaces entwickelten knapp ein Dutzend Studierende des Masterstudienganges „Angewandte Informatik“ unter der Leitung von Dipl.-Ing. Rolf Kruse (Vertretungsprofessur Mediendesign) und Prof. Dr. Paul Grimm (Graphische Datenverarbeitung) Prototypen für Anwendungen, die ohne jegliche Eingabegeräte, sondern allein durch die Bewegungen des Nutzers funktionieren.

Neben den o.g. Autoren waren an der Konzeption und Realisierung folgende Studierende beteiligt: Stephan Benischke, Joerg Federwisch, Thomas Filbry, Eric Jahn, Erik Müller.

Problem Based Learning

Hintergrund und besondere Herausforderung war hier, dass alle Teilnehmern gemeinsam eine einzelne Präsentation für die Ausstellung „Mediale Lebens(t)räume“ der Thüringer Landesmedienanstalt (TLM) vom 27.6.-3.7. in Erfurt erstellen sollten. In Ergänzung zu Vorlesungen und Übungen ist die notwendige intensive Kollaboration und die öffentliche Erprobung in einem sehr realistischen Rahmen eine wertvolle Erfahrung und Vorbereitung für das Berufsleben.

2 Technischer Aufbau

Für die Realisierung werden verschiedene Medientechnologien wie u.a. Tiefenkameras, Avatare, generative Echtzeit-3D-Grafik, 3D-Rekonstruktion und Physiksimulation eingesetzt. Besondere Herausforderung ist hierbei der Einsatz solcher Technologien im Rahmen einer Ausstellung, bei der die Interaktivität für Menschen verschiedenen Alters und unterschiedlicher Medienkompetenz robust und intuitiv funktionieren muss.

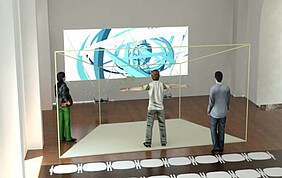

2.1 Spielfeld und Hardware

Der technische Aufbau besteht aus einer Breitbild-Projektion, Tiefen- und Farbkamera (Microsoft Kinect), PC mit leistungsfähiger Grafikkarte, Lautsprecher-System und Markierung der Interaktionszone auf dem Boden (ca. B 4,0 x T 4,5 m). Um die Bewegungserkennung sowie die Bild-darstellung nicht zu stören, darf kein direktes Sonnenlicht auf die Projektionsfläche oder das Spielfeld treffen.

2.2 Softwareframework

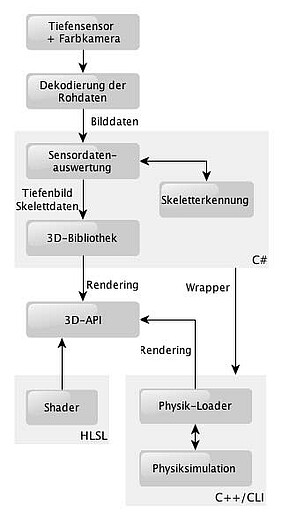

Die Daten der Sensoren werden mit speziellen Bibliotheken aufbereitet und an die Anwendung übergeben. Mittels 3D-Bibliothek, Shader-Programmen und Physiksimulation können komplexe, grafisch anspruchsvolle Animationen und Simulationen umgesetzt werden. Zur Verarbeitung der Daten des Tiefensensors kommen die Treiber und Bibliotheken von OpenNI zum Einsatz. Microsoft C# und XNA/DirectX werden als 3D-Bibliothek/API genutzt. Die Physik-simulation basiert auf NVIDA Apex und PhysX.

2.3 Interaktionskonzept

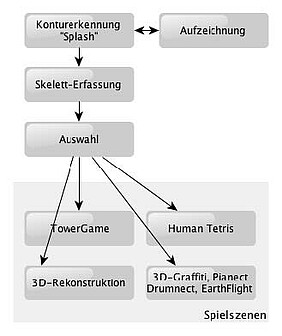

Ohne weitere Eingabegeräte, nur mit Bewegungen Ihres Körpers tauchen junge und ältere Besucher virtuell in interaktive 3D-Welten ein und erleben so spielerisch die Möglichkeiten neuer Technologien im Kontext der Geschichte eines der ältesten Häuser der Stadt Erfurt. Die erste Anwendung dient dazu, Aufmerksamkeit zu erzeugen und die Besucher zu ersten Interaktionen mit der virtuellen Welt anzuregen. Nach der Erkennung des Skeletons kann der Nutzer aus unterschiedlichen Herausforderungen an Geschicklichkeit und Kreativität auswählen.

2.4 „Splash“-Fluid Simulation

Ziel des Teilprojektes „Fluid Simulation“ ist es, jeden Passanten in Reichweite der Kinect zu einem aktiven Nutzer zu machen. Die Software erkennt automatisch die Silhouetten von einer oder mehreren Personen und versetzt diese in eine Echtzeit – Wassersimulation. Der Anwender kann durch Bewegung seines Körpers mit dem virtuellen Wasser interagieren. Die Berechnung des Wassers erfolgt mithilfe der Physiksimulation Physx und einem schnellen CUDA–fähigen GPU. Durch eine Geste kann der Anwender tiefer in die virtuelle Welt eintauchen und weitere Teilprojekte erkunden.

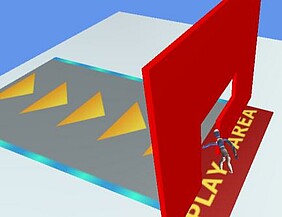

2.5 TowerGame

Beim Tower Game erfährt der Benutzer eine ganz neue Dimension der Interaktion, indem er seine virtuelle Umgebung dank Kinect frei und physikalisch korrekt manipulieren kann. Die Reaktion der Objekte auf den Nutzer wird von der Physik-Engine PhysX berechnet und mit eigenen HLSL-Shadern in Szene gesetzt. Die Anlehnung an das bekannte Spielprinzip von "Wackelturm" soll dem Benutzer dabei zur initialen Interaktion animieren. Mit einer speziellen Geste, deren Muster in einer Ecke eingeblendet wird, lässt sich der Turm zurücksetzen, um den ursprünglichen Zustand wiederherzustellen.

2.6 Human Tetris

Das berühmte Tetris des russischen Programmierers Alexei Paschitnow kennt wohl nahezu jeder. Nach dem Prinzip der Formvorgabe und der Anpassung muss sich bei Human Tetris allerdings dieses Mal der Nutzer selbst verbiegen. Bei den wildesten Verrenkungen werden nicht nur die eigenen Muskeln gedehnt, sondern bestimmt auch der Lachmuskel des ein oder anderen Zuschauers beansprucht.

2.7 3D-Rekonstruktion

Mit Hilfe von drei Tiefenkameras, die eine feste und bekannte Position im Raum haben, wird in Echtzeit ein räumliches Oberflächenmodell der erfassten Personen und Gegenstände erstellt. Die Bilder der ebenfalls vorhandenen Farbkamera werden zum einen für eine passende Textur genutzt als auch dazu, die Tiefenbilder aufeinander abzustimmen (Matching). Dazu werden mittels SURF-Algorithmus Merkmals-Punkte (Features) bestimmt, die in zwei Bildern zu sehen sind. Anhand dieser erfolgt anschließend ein Matching. Der Nutzer kann sich somit in Zukunft selbst in das Videospiel „beamen“ und Dinge tun, die er in der Realität nie tun könnte. Dieser Projektteil befindet sich derzeit noch in Bearbeitung.

2.8 Weitere Prototypen

Im Rahmen des Kurses sind weitere Ideen entwickelt und teilweise umgesetzt worden:

- „Kinect Graffiti“ macht den Benutzer zum Bildhauer, indem er Formen in den Raum „malen“ kann. Dabei wird mit grafischen Stilmitteln wie einem Feuereffekt gezeigt, welche Vorteile eine virtuelle Simulation gegenüber der Realität hat.

- Freunde klassischer Musik können mit „Pianect“ ihre Fähigkeiten am virtuellen Klavier unter Beweis stellen. Ganz ähnlich können mit „Drumnect“ all jene, denen ein reales Schlagzeug im Wohnzimmer zu groß ist, sich nun ihren Wunsch erfüllen.

- Per Ganzkörper-Geste steuert man virtuell über die Welt (auf Basis von Google Maps).